聴覚障害を持つ患者さんから、

「スマホを買いたいから一緒に選んで欲しい」

と、ご相談を受けました。

機種を選定している中で、ロボホンというスマホで、手話の通訳ができるアプリが開発された事を知りました。

ロボホンとはどんなスマホでしょうか?

手話をどうやって通訳しているのでしょうか?

この技術は、他の障害を持つ方々には応用できないのでしょうか?

目次

ロボホンとは?

出展:Bidbuy

ロボホンとは、ロボットクリエイターの高橋智隆氏とシャープが共同で開発した、ロボットとスマホが合体したものです。

身長は19.5cmで、二足歩行や立ち上がりなどもできる本格的なロボットとしての機能と、

スマホとして、Android 5.0ベースで、Web検索、地図検索、メモ、アラームなど、スマホとしての機能を一通り備えています。

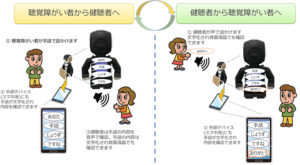

どうやって手話を通訳する?

聴覚障害者がロボホンに向かって手話をすると、ロボホンがAI技術(ディープラーニング)で手話の動きを映像として認識し画像解析します。

解析した手話の意味する単語を日本語でロボホンが発声すると同時に、スマートフォンなどに文字として表示してくれます。

出展:NTT DATA

出展:NTT DATA

ロボホンの技術は、他の障害へ応用できるか?

このアプリを実現した技術は、AI(人工知能)技術のディープラーニング(深層学習)という技術です。

AIの学習手段にはいろいろなものがありますが、

このディープラーニングは、画像や時系列、自然言語処理といったメディアに強いという特徴があります。

今回、ご紹介したロボホンも、ロボホンがカメラで撮った映像を情報として学習していき、処理した情報を人間に提供してくれるというものです。

この画像解析のAI技術を応用すれば、他の障害のアプリも作れるのでは?

と考えましたので、期待するシーンを挙げていきます。

聴覚障害

手話の通訳だけではなく、画像解析の技術は、

口の動きを読み取る”読唇術”にも応用ができるのではないかと考えました。

読唇術ができるようになれば、聴覚障害者にとって、

社会生活の中で役に立つ場面がグンと増えるのではないかと思います。

言語障害

言語障害は、言葉は聞き取れても話す事が難しい「運動性失語」という症状があります。

例えば、「時計」という言葉を出したくても出て来なかったり、どうしても「車」と言ってしまったりするような症状です。

この症状は、電話ではコミュニケーションが取れませんし、

音声だけではなく字を書く時にも同様の症状が出る場合があり、筆談やPC・スマホなどで文字を入力して伝える事もできない事があります。

そこで、画像解析の技術を使って、伝えたい物の映像を音声にして電話で伝えたり、文字にして文章を作るなどができれば、助かるのではないかと考えます。

肢体不自由

肢体不自由でも「構音障害」という、言葉を話しにくい症状があります。

文字を書けたり、PC・スマホが使えれば筆談という伝達手段がとれますが、

手が不自由だとこれもできません。

そこで、伝えたいものの写真を撮るだけで、音声や文字として相手に伝える技術ができれば非常に助かります。

視覚障害者

カメラで撮っている映像をリアルタイムで音声にしてくれるという技術が可能になれば、

視覚で認識しなければわからない情報を音声で表現できます。

例えば、

カメラを構えた方向で知り合いが手を振っていたら

「〇〇さんが手を振っています」

と教えてくれたり、

また、この技術をインターホンに組み込めば防犯にもなり、

知り合いの画像を登録しておけば、カメラに映った時点で名前を音声で教えてくれて、

知り合いの名を語った他人と区別できますし、

「荷物です」としか言わない宅配便も、制服を認識して、本物かどうかの判断もできるようになると思います。

発達障害

発達障害の中で、ADHD(注意欠如多動性障害)という症状がありますが、

このADHDは、必要なことに注意を向けるのが苦手で、物・人を探すのが苦手です。

普通の人ならすぐ目の前にあるような物、知っている顔などでも、

見付けられない、わからない事があります。

これを画像で解析して、音声や文字にして教えてあげられたら失敗も少なくなります。

また、学習障害を持つ方は、文章を作るのが苦手ですが、この技術で、風景などを言語化して文章にする事が出来れば、

「こんな場面はこうやって表現すれば良いんだ」

という文章表現の見本を示してくれるようになると思います。

高次脳機能障害

高次脳機能障害の中に”注意力障害”というものがありますが、

これは特定の物や人に注意を向けられない症状です。

この症状があると普通に歩いていても物にぶつかり易かったり、躓きやすくなったりします。

画像解析で、ぶつかりそうな物や躓きそうな物があれば、それを音声で未然に注意してくれれば事故を防ぐ事ができます。

また、特定の物や人、景色などの認識が難しいため、

物・人・景色を探す事も難しいので、

画像の解析として物・人・景色を探す手伝いも出来るのではないかと考えます。

手話を通訳できるロボホン AI技術は他の障害へも応用できる? まとめ

1 ロボホンとは?

ロボットクリエイターの高橋智隆氏とシャープが共同で開発した、ロボットとスマホが合体したもの。

2 どうやって手話を通訳する?

ロボホンがAI技術(ディープラーニング)で手話の動きを映像として認識し画像解析して、日本語でロボホンが発声すると同時に、スマートフォンなどに文字として表示する。

3 ディープラーニングは、他の障害へ応用できるか?

AI(人工知能)技術のディープラーニング(深層学習)という技術で他の障害にも応用できるのでは?と考えた。

3.1 聴覚障害

手話の通訳だけではなく、口の動きを読み取る”読唇術”にも応用ができるのではないか。

3.2 言語障害

運動性失語に対して、画像解析の技術を使って伝えたい物の映像を音声にして電話で伝えたり、文字にして文章を作るなどができるのではないか。

3.3 肢体不自由

構音障害に対して、伝えたいものの写真を撮るだけで、音声や文字として出せるのではないか。

3.4 視覚障害者

カメラで撮っている映像をリアルタイムで音声にしてくれるという技術が可能になれば、視覚で認識しなければわからない情報を音声で認識できる。

3.5 発達障害

画像で解析して、音声や文字にして教えてあげられたら失敗も少なくなる。

文章表現の見本を示してくれるようになる。

3.6 高次脳機能障害

画像の解析として物・人・景色を探す手伝いも出来る。

近年、AIなどの先進技術の発達には、目覚ましいものがあります。

手話を通訳する技術として、今回ご紹介したロボホンの他にも、

ハンガリーのブダペストを拠点とする「SignAll」も、別の方法で開発を進めています。

今回は、これらの先進技術を活かして障害者のサポートをしてくれるアイデアを挙げてみましたが、

IT素人の私が考えるアイデアですから、既に実現している技術もあるでしょうし、そんなに難しいものではないと思います。

もし、この記事をハードやソフトを開発される方が見て下さっていたら、

先進技術がたくさんの障害者を救うという事を、頭の片隅でも良いので置いておいて頂けたら嬉しいです。

テクノロジーの発達で、障害を持った方々が暮らしやすくなる世の中になる事を祈っています。

というか、信じています♪